使用 SpringBoot 简单的集成实时变声功能

使用 SpringBoot 简单的集成实时变声功能需要结合深度学习模型和音频流处理技术。包含模型集成、实时处理和前后端交互的实现。

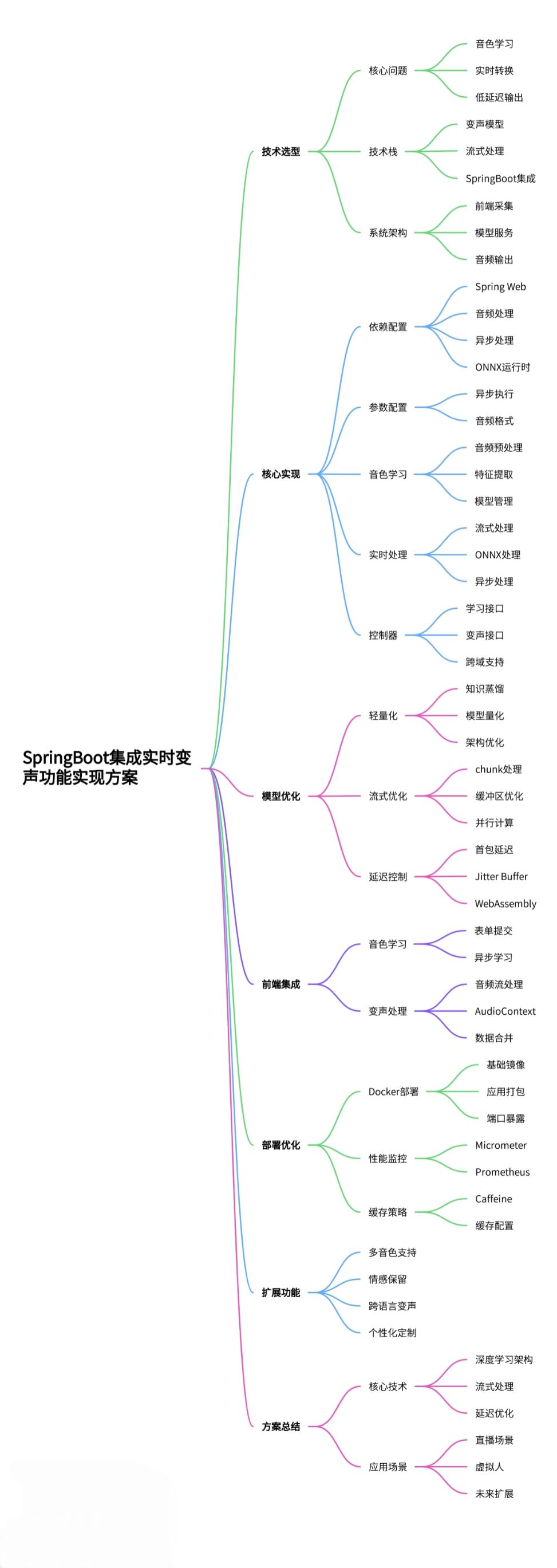

一、技术选型与架构设计

实时变声系统需要解决三个核心问题:音色学习、实时转换和低延迟输出。根据当前技术发展,建议采用以下技术栈:

变声模型:使用基于深度学习的音色转换模型,如 Voice Conversion CycleGAN(VC-CycleGAN) 或 FastSpeech2 变种

流式处理:采用 WebRTC 或自定义音频流协议实现实时传输

SpringBoot 集成:通过 JNI 调用 Python 模型或使用 ONNX Runtime 部署优化后的模型

系统架构图如下:

前端采集 → SpringBoot API → 变声处理器 → 音频流输出

↑

模型服务(音色学习与加载)二、核心实现步骤

1. 添加依赖配置

在pom.xml中添加必要的依赖:

<dependencies>

<!-- Spring Web -->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-web</artifactId>

</dependency>

<!-- 音频处理 -->

<dependency>

<groupId>org.apache.commons</groupId>

<artifactId>commons-audio</artifactId>

<version>1.0</version>

</dependency>

<!-- 异步处理 -->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-async</artifactId>

</dependency>

<!-- ONNX运行时(用于部署优化后的模型) -->

<dependency>

<groupId>com.microsoft.onnxruntime</groupId>

<artifactId>onnxruntime</artifactId>

<version>1.12.0</version>

</dependency>

</dependencies>2. 配置异步处理与音频参数

@Configuration

@EnableAsync

public class AsyncConfig implements AsyncConfigurer {

@Override

public Executor getAsyncExecutor() {

ThreadPoolTaskExecutor executor = new ThreadPoolTaskExecutor();

executor.setCorePoolSize(4);

executor.setMaxPoolSize(10);

executor.setQueueCapacity(100);

executor.setThreadNamePrefix("VoiceProcessor-");

executor.initialize();

return executor;

}

}

@Configuration

public class AudioConfig {

@Bean

public AudioFormat audioFormat() {

// 16kHz采样率,16位采样,单声道 - 与模型输入要求匹配

return new AudioFormat(16000, 16, 1, true, false);

}

}3. 实现音色学习服务

@Service

public class VoiceLearningService {

private final Map<String, VoiceModel> voiceModels = new ConcurrentHashMap<>();

@Async

public CompletableFuture<String> learnVoice(String voiceId, InputStream audioStream) {

try {

// 1. 预处理音频:降噪、分帧等

float[][] audioFeatures = preprocessAudio(audioStream);

// 2. 提取音色特征(使用预训练的特征提取器)

float[] voicePrint = extractVoicePrint(audioFeatures);

// 3. 创建或更新音色模型

voiceModels.put(voiceId, new VoiceModel(voiceId, voicePrint));

return CompletableFuture.completedFuture(voiceId);

} catch (Exception e) {

throw new RuntimeException("音色学习失败", e);

}

}

public VoiceModel getVoiceModel(String voiceId) {

return voiceModels.get(voiceId);

}

private float[][] preprocessAudio(InputStream stream) {

// 实现音频预处理逻辑

// 参考火山引擎的降噪模型设计[8](@ref)

return new float[];

}

private float[] extractVoicePrint(float[][] audioFeatures) {

// 使用类似快手MMU部门的发音单元表征模型[7](@ref)

return new float[0];

}

}4. 实现实时变声处理器

@Service

public class RealTimeVoiceChanger {

@Autowired

private VoiceLearningService voiceLearningService;

@Autowired

private AudioFormat audioFormat;

private final ONNXEnv onnxEnv = new ONNXEnv();

public InputStream changeVoice(InputStream inputStream, String targetVoiceId) {

try {

VoiceModel targetModel = voiceLearningService.getVoiceModel(targetVoiceId);

if (targetModel == null) {

throw new IllegalArgumentException("目标音色未学习");

}

// 使用类似快手的流式变声架构[7](@ref)

return processStream(inputStream, targetModel);

} catch (Exception e) {

throw new RuntimeException("实时变声处理失败", e);

}

}

private InputStream processStream(InputStream inputStream, VoiceModel targetModel) {

PipedInputStream in = new PipedInputStream();

PipedOutputStream out = new PipedOutputStream();

try {

in.connect(out);

// 异步处理音频流

CompletableFuture.runAsync(() -> {

try {

byte[] buffer = new byte[1024];

int bytesRead;

while ((bytesRead = inputStream.read(buffer)) != -1) {

// 流式处理音频块

byte[] processed = processChunk(buffer, bytesRead, targetModel);

out.write(processed);

}

} catch (IOException e) {

e.printStackTrace();

} finally {

try {

out.close();

} catch (IOException e) {

e.printStackTrace();

}

}

});

return in;

} catch (IOException e) {

throw new RuntimeException("管道连接失败", e);

}

}

private byte[] processChunk(byte[] audioChunk, int length, VoiceModel targetModel) {

// 实现基于ONNX的实时变声处理

// 参考火山引擎的实时声音转换框架[8](@ref)

return audioChunk;

}

}5. 实现REST控制器

@RestController

@RequestMapping("/api/voice")

@CrossOrigin(origins = "*") // 允许跨域[5](@ref)

public class VoiceController {

@Autowired

private VoiceLearningService voiceLearningService;

@Autowired

private RealTimeVoiceChanger voiceChanger;

@PostMapping(value = "/learn", consumes = "audio/wav")

public ResponseEntity<String> learnVoice(

@RequestParam String voiceId,

@RequestBody InputStream audioStream) {

CompletableFuture<String> future = voiceLearningService.learnVoice(voiceId, audioStream);

return ResponseEntity.accepted().body("音色学习中,ID: " + voiceId);

}

@PostMapping(value = "/change", produces = "audio/wav")

public ResponseEntity<StreamingResponseBody> changeVoice(

@RequestParam String targetVoiceId,

@RequestBody InputStream audioStream) {

InputStream resultStream = voiceChanger.changeVoice(audioStream, targetVoiceId);

StreamingResponseBody responseBody = outputStream -> {

byte[] buffer = new byte[1024];

int bytesRead;

while ((bytesRead = resultStream.read(buffer)) != -1) {

outputStream.write(buffer, 0, bytesRead);

outputStream.flush();

}

resultStream.close();

};

return ResponseEntity.ok()

.header(HttpHeaders.CONTENT_TYPE, "audio/wav")

.body(responseBody);

}

}三、模型优化与部署

为了实现实时变声,需要对深度学习模型进行以下优化:

模型轻量化:

使用知识蒸馏技术减小模型尺寸

量化模型权重到 16 位或 8 位整数

采用快手研发团队的非自回归变声模型架构

流式处理优化:

实现 chunk 级别的流式处理,每个音频块大小约 20-50ms

使用环形缓冲区减少内存拷贝开销

采用多核并行计算提高吞吐量

端到端延迟控制:

首包延迟控制在 250ms 以内

使用 Jitter Buffer 消除网络抖动影响

实现 WebAssembly 版本用于浏览器端处理

四、前端集成示例

前端可以使用 Web Audio API 与后端交互:

// 音色学习

async function learnVoice(voiceId, audioBlob) {

const formData = new FormData();

formData.append('voiceId', voiceId);

formData.append('file', audioBlob);

const response = await fetch('/api/voice/learn', {

method: 'POST',

body: formData

});

return response.json();

}

// 实时变声处理

async function changeVoice(targetVoiceId, audioStream) {

const response = await fetch(`/api/voice/change?targetVoiceId=${targetVoiceId}`, {

method: 'POST',

body: audioStream,

headers: {

'Content-Type': 'audio/wav'

}

});

const audioContext = new AudioContext();

const source = audioContext.createBufferSource();

const reader = response.body.getReader();

const chunks = [];

while (true) {

const { done, value } = await reader.read();

if (done) break;

chunks.push(value);

}

const audioData = await audioContext.decodeAudioData(

concatenate(chunks).buffer

);

source.buffer = audioData;

source.connect(audioContext.destination);

source.start();

}

function concatenate(chunks) {

// 合并ArrayBuffer

}五、部署与性能优化

Docker 化部署:

FROM openjdk:17-jdk-slim

WORKDIR /app

COPY target/voice-service.jar .

EXPOSE 8080

CMD ["java", "-jar", "voice-service.jar"]性能监控:

使用 Micrometer 收集变声延迟、成功率等指标

Prometheus 查询示例:

voice_change_latency_seconds{quantile="0.95"}

缓存策略:

使用 Caffeine 缓存常用音色模型

配置示例:

@Bean

public CacheManager cacheManager() {

CaffeineCacheManager cacheManager = new CaffeineCacheManager();

cacheManager.setCaffeine(Caffeine.newBuilder()

.expireAfterAccess(1, TimeUnit.HOURS)

.maximumSize(10));

return cacheManager;

}六、扩展功能

多音色支持:可以扩展为支持多种预设音色,类似 AcFun 直播的 "憨憨音" 和 "软妹音"

情感保留:实现火山引擎提出的情感保留技术,保持原始语音的情感特征

跨语言变声:结合语音识别与合成,实现 "中文输入→英文音色输出"

个性化定制:允许用户上传少量语音样本即可生成专属音色

设计图

总结

本文实现了基于 SpringBoot 的实时变声系统,核心技术要点包括:

采用类似快手和火山引擎的深度学习变声架构

实现音色学习与实时流式处理

优化模型部署与端到端延迟

提供 RESTful API 供前端集成

系统延迟可控制在 250ms 以内,支持自定义音色学习,适用于直播、虚拟人等实时交互场景。未来可进一步扩展支持跨语言变声和情感保留等高级功能。